こんばんは!サキナオコです^^ もう眠いので簡単に。 あ、そうそう昨日はネガティブプロンプトに挑戦して やはりネガティブプロンプト入れるとわりといい結果になるんだなと思いました。 そして今日やってみたかったimg2imgをやってみました! Stable DiffusionをGoogleColabでやってしかもimg2imgでやってみたかったので。 画像を読みこんでそれを元にAIに新たな画像にしてもらうっていうことなんですけど、なかなかうまく動かず焦りましたが、なんとかできました! Pythonに慣れていてよかったと思いました。 で、やってみたら、どうです、これ。 元の画像読み込む意味あるのかな、ってくらいな感じで…

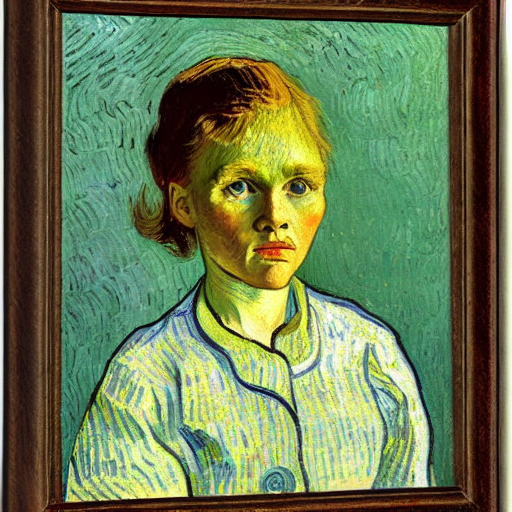

それを元にAIが作成したもの以下(2日にわたり書いてます)

ううむ、まあ似てるっていえば似てるのか。。構図はなんとなく似てる。 口が、元のイラストの口に似てるのも多い。 上の2枚は体の向きが似てる。左下は元画像関係あるか?っていう… ええっとコードが間違ってるとかで元画像無視しちゃってたらどうしよう。 と思いながらもうほんと眠いんで寝ます。 はい、翌日です。 img2imgでしばらくやってみてわかったのは、構図とか体の向きとかがなんとなく似るということ。 あと髪の毛の色、質感、長さみたいなものとか反映されているよう。 何かもっと近づける数値をなんとかすればイメージに近くなるのかも。 という感じですねー。 AIが受け取る感じって寝て見る夢の中みたいな感じなのかなあ。 それっぽいけど、それがちゃんと認識されたものじゃないっていう。 そしてへんに細かかったりするみたいな。 ということはちゃんと教えてあげないといけないってことですね。

コメントを残す